12月

13

12月

13

通过 git 的方式,很难下载到 huggingface。于是就网上找方法,还真找到了方法。

https://zhuanlan.zhihu.com/p/663712983

上边链接总结了多种方法。这里,只选他说的最好用的方法,使用 huggingface-cli。不做选择其他选择。这里是尝试快速下载过模型。

准备

- 科学上网

- 该有的 python 环境

操作

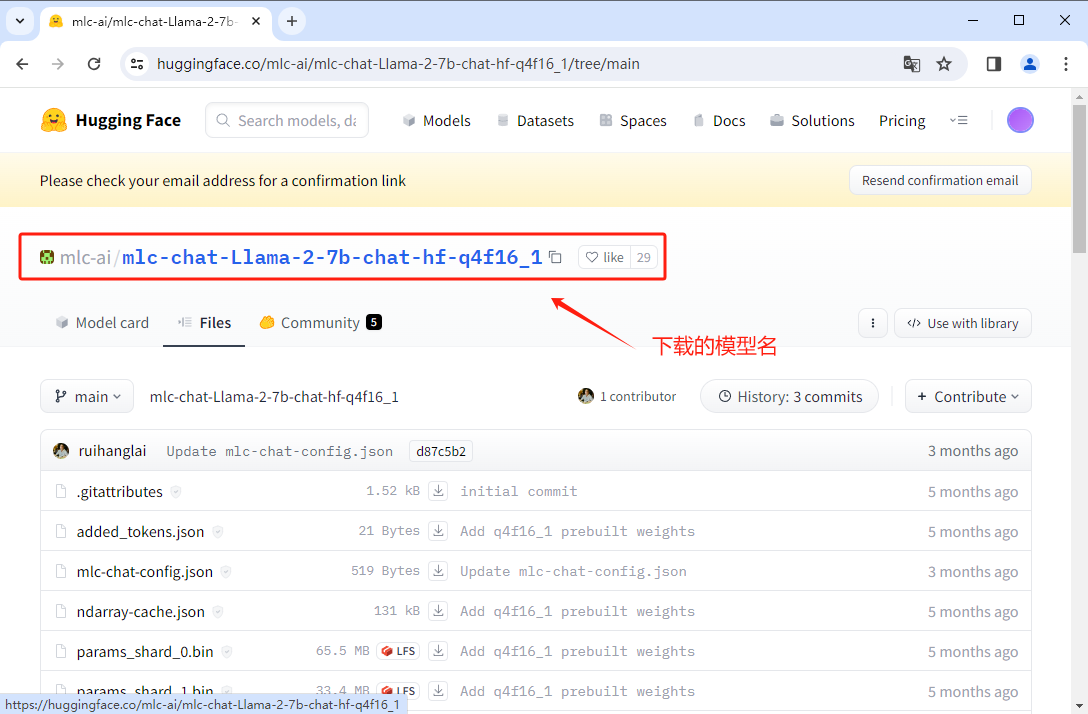

以下载 https://huggingface.co/mlc-ai/mlc-chat-Llama-2-7b-chat-hf-q4f16_1/tree/main 模型为例。

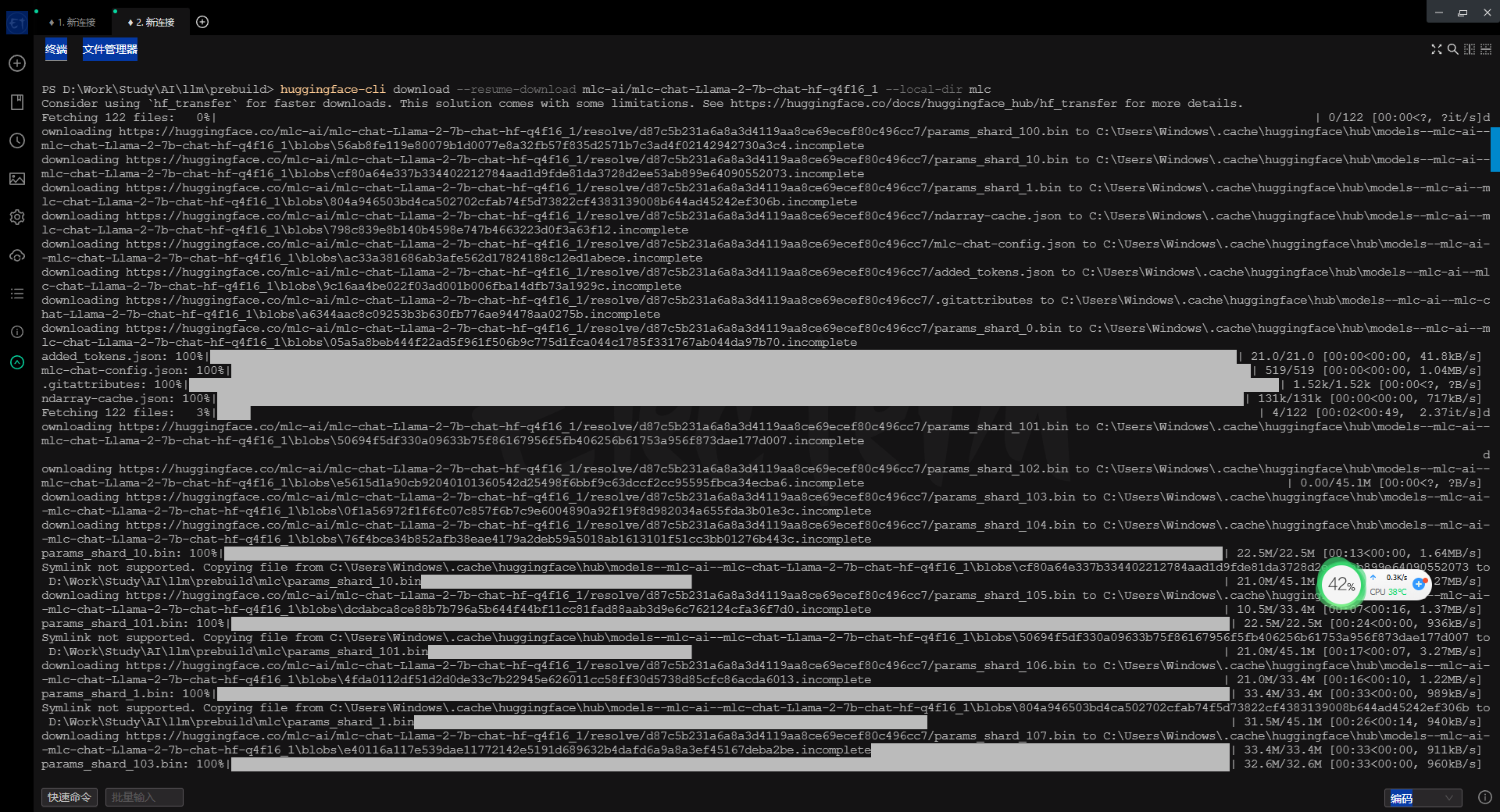

打开终端

# 安装 huggingface-cli

pip install -U huggingface_hub

# 使用

# --resume-download 要下载的模型名

# --local-dir 下载保存的位置

huggingface-cli download --resume-download mlc-ai/mlc-chat-Llama-2-7b-chat-hf-q4f16_1 --local-dir mlc

好了,仅仅这样就好了。下载速度还是很快的,也有进度条。

win 的终端终究没 mac 的 iterm2 好用。不过 win 的进步速度比 mac 快多了。感觉 mac 几乎在吃老本。在多显示器的快捷键操作上,win 的体验却要比 mac 好。仅有一点 win 比 mac 差,就是多显示器中,某个显示器内的窗口切换。 win 会将所有的显示器都切换了,mac 会针对选择的显示器进行切换。

使用 hf_transfer

hf_transfer 依附并兼容 huggingface-cli,是 hugging face 官方专门为提高下载速度基于 Rust 开发的一个模块

安装: pip install -U hf-transfer

开启(linux/mac): export HF_HUB_ENABLE_HF_TRANSFER = 1

开启(win): $env:HF_HUB_ENABLE_HF_TRANSFER = 1

使用: huggingface-cli download --resume-download mlc-ai/mlc-chat-Llama-2-7b-chat-hf-q4f16_1 --local-dir mlc